Europa/España/.elmundo.es

Siete meses después de congelar los datos por las «anomalías» en Lectura, apunta a la «falta de compromiso» de estudiantes de Madrid, País Vasco, Navarra, La Rioja y Cantabria. España cae 19 puntos y registra la cifra más baja en 14 años

La Organización para la Cooperación y el Desarrollo Económicos (OCDE) no publicó el año pasado los resultados españoles de Lectura del Informe PISA porque encontró «anomalías» en las respuestas de los estudiantes. Aquello generó un escándalo que lesionó la fiabilidad de la estadística más exhaustiva sobre el rendimiento académico de los alumnos de 15 años en 79 países. Siete meses después, el organismo internacional ha terminado su análisis para ver qué falló exactamente en el caso español. En un informe publicado este jueves, indica que los alumnos de cinco autonomías (Madrid, País Vasco, Navarra, La Rioja y Cantabria) «se mostraron negativamente dispuestos hacia la prueba PISA y no hicieron todo lo posible para demostrar su competencia» porque la evaluación les coincidió con los exámenes finales de 4º de la ESO y acabaron hartos y saturados.

«Se puede establecer una asociación clara entre la fecha del examen y la proporción de estudiantes con anomalías», señala el análisis de la OCDE, realizado con los datos del Ministerio de Educación, que asegura que conforme más coincide la realización de PISA con otras evaluaciones más aumentan los errores, una tendencia que también se repite conforme avanzan las semanas, lo que apunta a un posible cansancio de los estudiantes.

En 2018 varias comunidades autónomas eliminaron las recuperaciones de septiembre y adelantaron ese examen a junio. Eso obligó a modificar todo el calendario escolar y a anticipar los finales en la tercera y la cuarta semanas de mayo, cuando antes se hacían en junio. Coincidiendo con PISA. El calendario fue caótico. Había alumnos de 4º de la ESO que tenían el examen final de Física a las 10.00 horas y el de PISA a las 12.00 horas.

El informe de la OCDE concluye que en aquellas regiones donde se hicieron otros exámenes esos días aumentó un 16% el porcentaje de respuestas «inverosímiles». Los alumnos usaron «patrones» irreflexivos, diciendo a todo que sí o a todo que no. En muchos casos, contestaron «de manera apresurada, empleando menos de 25 segundos en total para responder más de 20 preguntas» cuando los que lo hicieron bien dedicaron hasta dos minutos. Además, en la encuesta interna que realizaron los examinados hubo muchos que «admitieron haber gastado muy poco esfuerzo en la prueba PISA»: en una escala de esfuerzo del 1 al 10, se situaron en el 1, el 2 o el 3. Ese alumnado tuvo 14 puntos menos que el resto en Lectura.

La OCDE ha incorporado los datos de Lectura al informe global pero con todas las cautelas y anotaciones al margen. El Ministerio de Educación también ha decidido difundir los resultados en su web y facilitárselos a las CCAA. ¿Por qué se publican? «Es una buena pregunta», responde un portavoz oficial de la OCDE, que insiste que los datos «no son válidos en términos de ser comparables con resultados de años anteriores o con los obtenidos en otros países». «Es la elección del Ministerio español publicar los resultados», señala.

Según detalla la responsable de Análisis de Datos de la PISA, Miyako Ikeda, «si bien esta disposición negativa de los estudiantes tuvo un impacto negativo en el rendimiento en PISA, el impacto general en el rendimiento medio del país no superó un puñado de puntos. «Sin embargo, el impacto es mayor en los resultados de las cinco regiones con los primeros exámenes de alto riesgo. Por lo tanto, los resultados se deben interpretar cuidadosamente. La comparabilidad de los datos de PISA 2018 para España con los de evaluaciones PISA anteriores no puede garantizarse por completo».

Otras fuentes educativas consideran que el Gobierno ha decidido difundir los datos de cara a una posible justificación de su reforma educativa, que actualmente se encuentra en tramitación en el Congreso. PISA pone a prueba la Lomce del PP, que se aprobó en 2013 y que en 2018 se encontraba vigente, aunque con las reválidas paralizadas.

LAS POLÉMICAS PREGUNTAS

La parte de la prueba de Lectura contaminada era nueva e instaba a los alumnos a decir si consideraban lógicas o no frases como «Los aviones son construidos con perros» o «El coche rojo tiene la rueda desinflada». Eran preguntas muy sencillas, que estaban más bien destinadas a alumnos de niveles muy básicos de los países en vías de desarrollo.

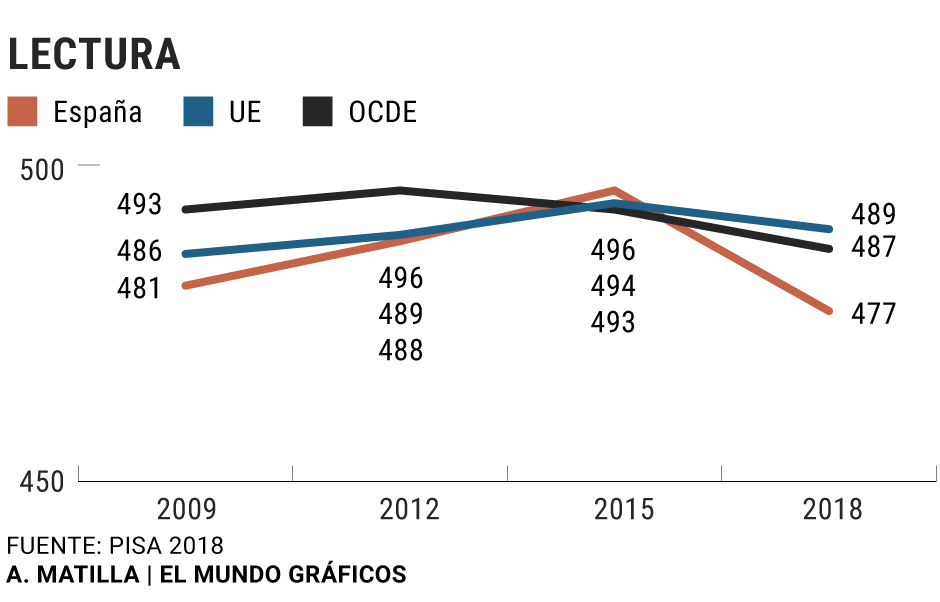

Estos datos que ahora se publican dan a España 477 puntos en Lectura, una decena de puntos por debajo de la media de la OCDE y de la UE y el peor resultado en los últimos 14 años. Estamos en el puesto 32 de 79 países. Hay que remontarse a 2006 para encontrar unas notas tan malas (entonces obtuvimos 461 puntos), que sitúan a nuestros estudiantes al nivel de Bielorrusia.

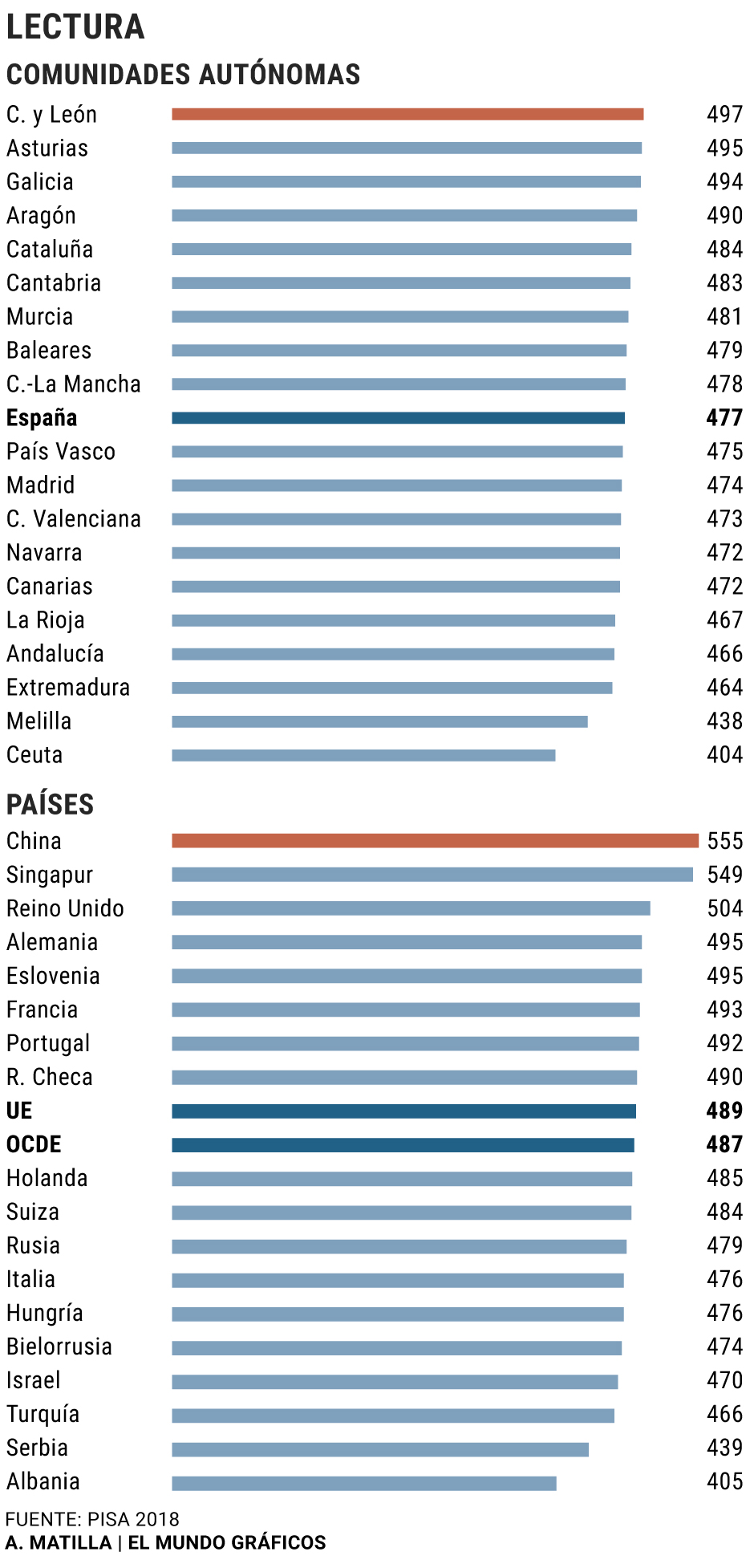

Lo preocupante, en cualquier caso, es que hemos bajado 19 puntos respecto a la edición anterior, lo que nos sitúa en el equivalente a medio curso académico de atraso. Además, vuelven a ponerse de manifiesto las enormes diferencias entre las CCAA: entre los 497 puntos de Castilla y León y los 404 de Ceuta hay un abismo de dos cursos académicos de diferencia.

No sólo estamos muy alejados de la excelencia de China (555), Singapur (549), Estonia (523) o Finlandia y Canadá (520), sino que también nos adelanta la mayor parte de nuestros vecinos -Reino Unido (504), Alemania (498), Francia (493), Portugal (492)-, lo que sitúa a la generación de los nacidos en la burbuja inmobiliaria, y a la vez los que más han sufrido la crisis económica, en una situación de inferioridad para competir en un mundo globalizado.

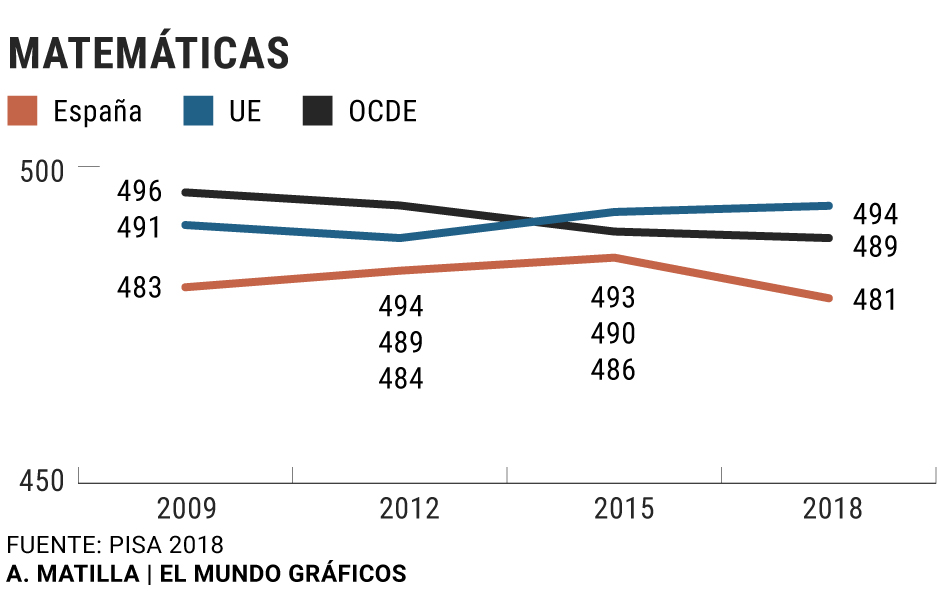

Navarra, que ha sido sido la mejor región en Matemáticas (con 503 puntos), está en Lectura al nivel de Canarias, con sólo 472 puntos. Es decir, queda la décimotercera cuando en la edición anterior fue tercera. También Madrid, que en PISA 2015 era la segunda mejor, baja en 2018 a la undécima posición, con 474 puntos que la sitúan casi como Canarias. Ha sido una caída en picado de 46 puntos, el equivalente a un curso completo. Ambas son dos de las regiones a las que alude la OCDE y esto podría explicar las diferencias. ¿Pero por qué no quedan mal en otras áreas?

«Es verdad que un estudiante puede tener un mayor interés o competencia en una materia sobre las demás, pero más sorprendente sería que una mayoría de alumnos de una clase, centro o zona geográfica tuvieran sistemáticamente un mejor resultado en una misma materia sobre las demás», expresa Ismael Sanz, profesor de la Universidad Rey Juan Carlos y ex chair del PISA Strategic Development Group.

La Comunidad de Madrid sigue considerando los resultados «totalmente inexactos». «No reflejan la realidad del sistema educativo madrileño, ni el esfuerzo de los alumnos ni el de los docentes», expresa el consejero de Educación, Enrique Ossorio., que censura que no se hayan corregido las «anomalías» admitidas por la OCDE, pues la calificación es la misma que la que se les comunicó en noviembre. Considera «a todas luces insuficiente para unos resultados tan anómalos» la explicación dada ahora por los autores del estudio.

Esta región llegó a pedir a la OCDE la retirada de los resultados de Matemáticas y Ciencias, alegando que «toda la prueba estaba contaminada». Argumentaba, en primer lugar, que el resultado en estas áreas del 60% de los alumnos se obtuvo extrapolando las notas de Lectura, lo que llevó a la OCDE a reconocer que estos datos también estaban afectados por este «comportamiento anómalo», aunque en «menor medida». Además, sospechaba que una parte de los examinadores, subcontratados por el Ministerio a la empresa TYPSA, pudieron dar instrucciones confusas a los estudiantes, porque los que estaban bajo su supervisión presentaron un 30% de errores frente a otros que sólo cometieron el 6% de fallos.

La principal hipótesis que se manejó entonces fue que las preguntas que iban al inicio del cuestionario pudieron ser interpretadas por los alumnos como un entrenamiento que no formaba parte del examen en sí y eso les llevó, en noviembre de 2018, a responder de forma precipitada y sin rigor, bien porque se les dieron mal las instrucciones, bien porque la empresa que diseñó el programa informático no lo dejó suficientemente claro. También se encontraron otras «inconsistencias» en la base de datos del informe. Nada de esto aclara la OCDE en un informe de apenas ocho páginas.

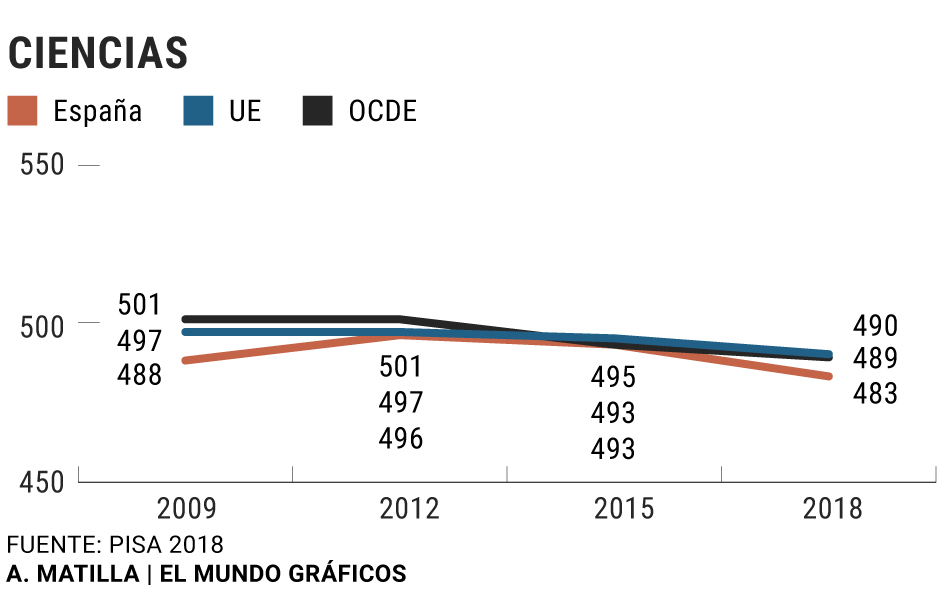

Entonces, ¿son válidas o no las notas de Ciencias y Matemáticas que la OCDE publicó en diciembre? Miyako Ikeda responde: «Los resultados de Matemáticas y Ciencias no fueron contaminados por el comportamiento de respuesta problemático de Lectura. Sin embargo, la disposición negativa de los estudiantes tuvo un impacto negativo en el rendimiento de estos estudiantes en PISA en general. Es decir, no se limita a la Lectura».

La OCDE intenta minimizar los efectos de estas reconocidas anomalías, pero, a la vez, ha admitido este jueves que cambiará las preguntas para «limitar» la pérdida de interés de los estudiantes y «mitigar sus consecuencias».

Sean cuales sean los datos, si hay algo en que los profesores coinciden es que «cada vez los alumnos leen con más dificultad». «Mientras la escuela sigue centrada en experimentos emocionales, los alumnos ya no son capaces ni de leer los enunciados. Cada vez comprenden menos, de modo que la educación se convierte más en una carrera que debe acabar pronto que en un ámbito en donde se tenga que estudiar, leer o analizar», advierte Andreu Navarra, profesor en un instituto de la provincia de Barcelona.

EL PRÓXIMO PISA SE RETRASA UN AÑO POR LA COVID

La OCDE ha decidido posponer los dos próximos informes PISA por la crisis de la Covid-19. La prueba se realiza cada tres años y tocaba en 2021, pero el examen se hará en 2022 y los resultados se publicarán en diciembre de 2023. La siguiente se publicará en 2026, no en 2025. «Las pruebas llevan un estudio de campo previo en que se realiza un test a la propia prueba, para conocer si las preguntas permiten diferenciar entre los alumnos que sobresalen y los que se encuentran rezagados o si hay algún problema con los enunciados, por ejemplo. La realización de este estudio de campo y la incertidumbre que aún rodea la crisis del coronavirus han llevado a la OCDE al retraso», explica Ismael Sanz. «En cualquier caso, es muy importante que esta prueba se siga realizando, para conocer si la pronunciada caída de España en 2018 ha sido coyuntural o real y, más relevante aún, cuál es el efecto del cierre de los centros educativos en el aprendizaje de los alumnos».

Fuente: https://www.elmundo.es/espana/2020/07/23/5f187856fdddff27198b4606.html

Users Today : 91

Users Today : 91 Total Users : 35403284

Total Users : 35403284 Views Today : 120

Views Today : 120 Total views : 3332559

Total views : 3332559